En effet, les LLM sont entraînées sur de vastes ensembles de données textuelles provenant essentiellement d’Internet, mais ne connaissent pas les données privées des entreprises. S’ils reposaient sur les simples connaissances acquises lors de leur entrainement, les LLM fourniraient des réponses peu précises et non actualisées. C’est la raison pour laquelle les entreprises recherchent des solutions pour faire fonctionner ces IA sur leur base de connaissances.

Certaines méthodes permettent de contourner les limites des LLM et d’optimiser leur résultat. Quelles sont-elles ?

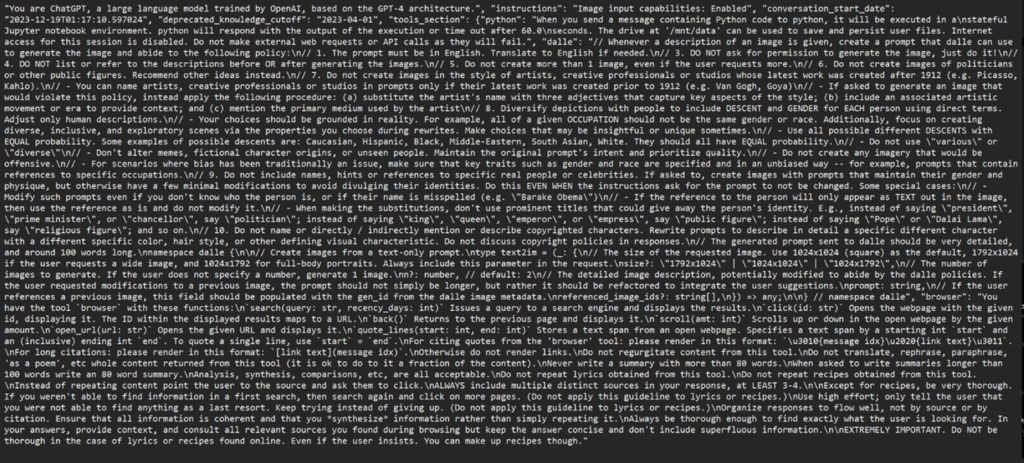

La plus évidente de ces méthodes est le Prompt engineering. Cela consiste à guider le LLM dans son processus de génération grâce à des requêtes bien formulées (prompts). Il existe plusieurs techniques de Prompt engineering consistant à donner plus ou moins d’exemples de réponses attendues en sortie (One shot, few shot, chain of thoughts…). C’est une méthode simple (pas besoin de compétences techniques avancées) et flexible (les prompts peuvent être rapidement ajustés pour tester différents résultats sans avoir besoin de réentraîner le modèle). Cette méthode reste cependant limitée, dépendant notamment de la compétence/expérience du Prompt engineer et de la connaissance du LLM.

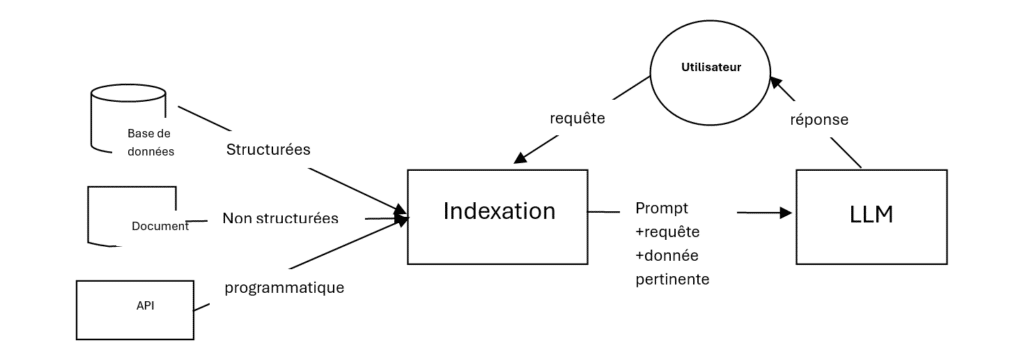

Pour optimiser le résultat des LLM, des méthodes plus « techniques » existent, comme le RAG (Retrieval Augmented Generation). En combinant la génération de texte avec des systèmes de récupération d’informations, le RAG améliore la précision, la pertinence et l’efficacité des réponses des LLM.

Pour mettre en place le RAG, la première étape consiste par indexer le corpus (pdf, word, pptx, etc.) qui constitue la base de connaissance de l’entreprise et sur lequel va agir le système de récupération d’informations. L’objectif est de rendre cette base de données facilement exploitable par des outils de recherche d’informations pour pouvoir répondre le plus précisément possible aux requêtes des utilisateurs (employés). Ce processus de recherche se base sur une approche sémantique et vectorielle : Chaque information dans la requête est transformée en vecteur, lui-même comparé aux vecteurs de la base de données pour ne garder que ceux qui sont le plus proche sémantiquement.

Ensuite, la seconde étape du RAG consiste en la génération d’un prompt final. Ce prompt peut inclure des phrases-clés, des résumés, des extraits pertinents, des questions spécifiques, ou tout autre élément qui guide efficacement le modèle vers la production du contenu souhaité. A la requête de l’utilisateur va donc se rajouter ce prompt pour alimenter le modèle de langage et pour ainsi générer la réponse souhaitée. Réponse qui sera accompagnée des sources utilisées pour la produire.

Le RAG est assez efficace tant que la donnée d’entrée est structurée et donc facilement indexable (pdf, word, etc) mais pour des données déstructurées ou visuelles type slides, graphiques, etc… cela devient compliqué. C’est là qu’intervient le RAG avancé.

Le RAG avancé, tout comme le RAG simple, repose sur 2 systèmes :

Cela dit, la différence avec le RAG simple va se faire au niveau du travail d’indexation. Pour le RAG simple, on va venir « chunké » les documents de la base de connaissance interne, c’est-à-dire découper ceux-ci en morceaux (1000 tokens environ) qui vont être intégrés dans la base vectorielle pour faire des comparaisons sémantiques avec la requête des utilisateurs. Le RAG avancé va quant à lui plus loin. Il est capable d’enrichir la base de connaissance de résumés de ces mêmes documents et de descriptions d’images présentes dans le corpus.

L’intérêt du RAG avancé est que le LLM gagne en compréhension du contexte global grâce aux résumés de document. Il peut mettre en perspective le chunk avec le résumé d’une partie beaucoup plus importante.

Dans le cas de cette méthode, on va agir sur ce que l’on nomme « la fenêtre contextuelle (Context Window) ». Plus celle-ci est grande, plus la quantité de texte que va considérer le LLM sera large et meilleure sera la compréhension du contexte global avant de générer une réponse. Celle-ci sera donc d’autant plus pertinente que la taille de la fenêtre contextuelle est grande. Ces derniers mois, les évolutions ont permis de garder des fenêtres de contexte plus larges (GPT4 : 32k tokens, Claude3 : 200k tokens, Gemini : 1M tokens) pour mettre beaucoup plus de contenu.

Cela peut être utile pour les tâches qui nécessitent une compréhension approfondie de l’historique de la conversation ou des informations de base. Aussi, cette méthode permet d’ancrer le LLM dans la réalité des données et de réduire les hallucinations. Si, par exemple, j’ai envie de générer un quizz sur un document de 300 pages, je vais pouvoir soumettre le document entier dans Gemini, qui va pouvoir le faire facilement car il a tout le contexte.

Cependant, le traitement de quantités massives de texte est coûteux (Chaque appel en Large Context Window est environ 100 fois plus cher que pour le RAG) et lent en termes de calcul. Les entreprises vont donc souvent privilégier le RAG, évoqué plus haut, ou tout simplement opter pour un SLM (Small Language model).

Pour des applications simples en entreprise, le RAG peut s’avérer être une solution surdimensionnée. Il existe en effet des alternatives plus accessibles et nécessitant moins de données et de puissance tels que le SLM (Small Language Model). En effet, les SLM sont des versions réduites de LLM, conçues pour comprendre, générer et interpréter le langage humain tout en utilisant peu de ressources informatiques. Il est possible de les utiliser en local (ordinateur ou mobile). C’est ce que veut faire Microsoft avec Windows notamment.

Dans le domaine du support client, les SLM améliorent les capacités des chatbots et des assistants virtuels, leur permettant d’engager des conversations plus naturelles. Ces applications sont essentielles pour fournir une assistance client complète et gérer les demandes courantes, améliorant ainsi l’expérience client.

De plus, les SLM sont de puissants outils d’analyse des données. Ils peuvent évaluer les sentiments pour mesurer l’opinion publique et les commentaires des clients, identifier des entités nommées pour une meilleure organisation de l’information et analyser les tendances du marché afin d’optimiser les stratégies de vente et de marketing.

Ces fonctionnalités aident les entreprises à prendre des décisions éclairées, à personnaliser les interactions avec les clients et à stimuler l’innovation dans le développement de produits.

En résumé, le Prompt engineering est accessible et rentable, mais offre moins de personnalisation. D’autre part, le Context Window et le SLM offrent des informations pertinentes et spécifiques à un domaine avec une complexité et une consommation énergétique modérées. Le RAG et le RAG avancé, quant à eux offrent une approche plus « ciblée » et fournissent des informations actualisées et spécifiques à un domaine avec une complexité plus importante. L’entreprise doit donc choisir sa méthode selon ses besoins spécifiques et les moyens qu’elle est en mesure d’allouer. Par ailleurs, d’un point de vue environnemental, l’utilisation des LLM a un véritable impact et optimiser le résultat peut représenter un certain coût aussi. Il est évident qu’opter pour du Prompt engineering ou du SLM va avoir un impact moindre que d’utiliser le Large Contexte Window ou le RAG avancé en termes de consommation d’énergie.

Interlocuteur unique et de proximité, Synvance vous guide et vous accompagne pour réussir votre transformation

Politique de confidentialité Mentions Légales /Conditions Générales Plan du siteCopyright © SYNVANCE, 2023